Le récent sommet français de l’IA a rassemblé les principaux acteurs du secteur – chercheurs, ingénieurs et professionnels de l’innovation – pour débattre d’un paysage en pleine mutation, marqué par des investissements massifs, une dynamique d’innovation intense, mais également par une fragmentation des visions et des approches réglementaires. Découvrez les points clés à retenir, proposés par nos trois experts, interrogés par Nicolas le Menn :

Nicolas Le Menn, associé Stanwell & WedR, accompagne les entreprises dans leurs projets de transformation, en mettant notamment l’accent sur les enjeux liés à l’IA.

Hugo Abraham, Lead AI chez WedR, implémente et de concrétise les usages IA, que ce soit pour des applications classiques ou avec les modèles LLM.

Adrien Basdevant, avocat inscrit au barreau de Paris et spécialisé en IA, propriété intellectuelle et intelligence artificielle, il collabore avec des développeurs de systèmes d’IA dans divers domaines – santé, assurance, mobilité – et accompagne les grands groupes dans l’intégration de ces technologies, en gérant les risques contractuels et les contentieux potentiels.

Jean Remond travaille au sein de la direction de la transformation stratégique et de l’innovation chez Generali : « Dans le cadre de notre plan stratégique « Boost 2027 », nous misons sur l’intelligence artificielle pour atteindre nos objectifs en termes d’excellence opérationnelle, d’amélioration de l’expérience client et collaborateur, et de croissance. Nous souhaitons déployer l’IA générative et développer l’ensemble des applications de l’IA, tout en plaçant l’humain au cœur de notre démarche, convaincus que la réussite passe par l’accompagnement de nos collaborateurs ».

Transcript du Webinar :

Nicolas le Menn :

La France vient de clôturer le sommet de l’IA avec de nombreuses annonces d’investissement dans les infrastructures, à la fois françaises et européennes. Pour commencer, quel est votre sentiment sur ce sommet ? Pouvez-vous le résumer en quelques mots, Adrien ?Adrien Basdevant :

Pour moi, les trois mots seraient : écosystème, investissement et fragmentation.Écosystème : Au-delà des annonces, ce sommet a été l’occasion de réunir en France tous les acteurs du domaine de l’IA – chercheurs, ingénieurs, et professionnels déployant ces systèmes – autour d’une table. C’était un moment nécessaire, porteur d’un esprit constructif et positif, pour rappeler qu’il faut continuer à bâtir et valoriser les talents existants.

Investissement : Des investissements ont été annoncés à la fois au niveau français et européen. Certes, certains se demanderont comment ces investissements seront coordonnés et à quoi ils serviront exactement, car toutes les réponses ne sont pas encore claires.

Fragmentation : Contrairement aux précédents sommets de Séoul ou du Royaume-Uni, qui se concentraient sur les enjeux à long terme et les risques existentiels, le débat s’est recentré sur des problématiques plus immédiates, comme l’impact sur l’emploi et la promotion de l’innovation pour le bien public. Un changement de paradigme s’est également dessiné en termes de discours, avec notamment la présence marquée du terme « open source » – quatre fois dans la salle française, alors qu’il était quasiment absent lors des précédentes éditions.

Un point notable est également l’absence de certains signataires dans la déclaration finale : les États-Unis, pour des raisons géopolitiques évidentes, et le Royaume-Uni, qui considérait certaines orientations comme un camouflet.

Ce nouveau paradigme se caractérise par une certaine fragmentation, opposant ceux qui prônent une dérégulation totale à ceux qui souhaitent simplifier la régulation afin de promouvoir l’innovation dans leur écosystème, sans pour autant l’abandonner totalement. Ce sujet fera l’objet d’analyses plus approfondies ultérieurement.

Nicolas le Menn :

Hugo, quel est ton ressenti ?Hugo Abraham :

J’adhère largement à ce que dit Adrien. Pour résumer, j’utiliserais trois mots : innovation, concrétisation et compétition.Innovation : Parce que tous les volets technologiques ont été mis en lumière, notamment avec des panels très intéressants sur l’open source. L’arrivée de D. Psy, par exemple, semble redonner de l’élan dans ce domaine. Cela a stimulé la réflexion de plusieurs centres de recherche, chacun se rendant compte qu’on n’a peut-être pas besoin d’être totalement anthropocentrique pour avancer, voire dépasser certains cadres traditionnels.

Concrétisation : On vient de reparler d’usage en délaissant quelque peu l’IA propriétaire pour se recentrer sur la valeur réelle et opérationnelle. Comme le soulignait Adrien, nous quittons peu à peu les discours apocalyptiques pour nous interroger sur la manière dont, dès demain, ces innovations pourront se mettre en œuvre concrètement dans les entreprises et quel impact économique elles auront, à court ou moyen terme.

Compétition : Il est évident que des tensions se font ressentir, notamment sur le plan géostratégique. Le discours de GDI Vans, prononcé mardi soir, était particulièrement virulent, illustrant bien ces tensions. On voit une organisation qui se met en place, notamment au sein de l’Union européenne, face à des ambitions chinoises et un enthousiasme débordant dans le Sud global. Il y a un véritable dynamisme, certes enthousiasmant, mais qui ramène aussi à la réalité – une réalité parfois intimidante et pleine de défis.

Nicolas le Menn :

Autrement dit, nous nous éloignons des projections à long terme pour arriver sur des annonces plus concrètes, même si cela peut laisser penser que, parfois, on ne retire pas suffisamment de bénéfices d’un sommet comme celui-ci.Jean Remond :

J’essaie de ne pas jouer les grincheux, mais si je devais résumer ce que j’en retiens : il y a, comme l’ont dit Adrien et Hugo, une effervescence palpable. L’enthousiasme et la mise en mouvement sont très stimulants – voire, pour être taquin, un peu tumultueux.Cela dit, on constate aussi beaucoup de contradictions, tant dans la société que dans notre rapport à l’intelligence artificielle. Il y a eu de nombreuses annonces d’investissements et des ruptures technologiques majeures, mais cela laisse aussi une impression d’incertitude. Une incertitude qui complique la coordination politique et les politiques d’investissement.

Il faudra clarifier ce que l’Union européenne et la France souhaitent précisément faire, comment les rôles seront répartis et comment les initiatives se concrétiseront. Par ailleurs, la réglementation reste encore floue malgré quelques éléments publiés récemment par l’UE pour guider cette mise en œuvre. En somme, il existe une dynamique indéniable, mais le contexte réglementaire et les investissements restent incertains malgré les annonces.

Nicolas le Menn :

Du coup, Adrien, peut-être pourrais-tu nous éclairer sur un point : on a l’impression que les aspects liés à la réglementation n’ont pas été vraiment mis en avant pendant le sommet, et qu’ils n’ont pas bénéficié de la même coordination avec les partenaires. Qu’en penses-tu ?Adrien Basdevant :

Si je peux me permettre, le sommet n’avait pas vocation à créer de la réglementation ni à préciser comment la réglementation votée depuis l’été dernier au niveau de l’Union européenne allait s’appliquer. Ce sont des discussions qui se déroulent en marge, et il y en a eu plusieurs, notamment avec la Commission européenne ces derniers jours à Paris.L’objet du sommet était plutôt axé sur la gouvernance internationale que sur l’application d’une réglementation régionale, comme le règlement dont nous parlons. Pour résumer, cette réglementation est entrée en vigueur à l’été 2024 avec une mise en œuvre progressive : certaines obligations prendront effet six, neuf, douze ou dix-huit mois plus tard, selon le rôle dans la chaîne de valeur. Par exemple, si vous êtes fournisseur d’un modèle à usage général, les obligations principales ne s’appliqueront qu’à partir de l’été 2025. En d’autres termes, les modèles commercialisés avant cette date ne seront pas concernés.

Pour ceux qui déploient des systèmes d’IA à haut risque – dans des domaines comme le recrutement, l’assurance ou la finance – il existe d’autres échéances, avec certaines obligations commençant en août 2026. Il est donc primordial de bien identifier sa position dans la chaîne de valeur – que l’on soit développeur ou déployeur – afin d’adapter sa stratégie et de dé-risker son approche.

Il est clair que le sommet n’était pas l’endroit pour détailler ces aspects techniques. Pour le moment, au niveau européen, la réglementation a été votée, mais son application concrète, notamment à travers les codes de pratique, reste en cours de définition. Nous avons, par exemple, vu la publication récente d’un code de pratique pour les IA à haut risque, et un autre devrait suivre la semaine prochaine. Ces précisions permettront d’éclaircir les obligations de documentation et de contractualisation, ainsi que les calendriers d’application.

Hugo Abraham :

Je voulais rebondir sur ce point. Lors du sommet, il a bien été question de réglementation, notamment avec les initiatives de l’OCDE et les accords d’Hiroshima qui, eux, relèvent d’un code de conduite. L’OCDE a également organisé plusieurs tables rondes à ce sujet. Toutefois, force est de constater que ces réflexions semblent avoir été reléguées au second plan, surtout quand on entend certains discours, notamment celui des États-Unis – un des contributeurs majeurs de l’OCDE – qui considèrent que la réglementation équivaut à de la censure.Jean Remon :

Ce que je constate, c’est un sentiment d’isolement vis-à-vis de l’AI Act au niveau mondial, notamment parce que la compétition internationale se structure très différemment. Certes, l’objectif du sommet n’était pas de préciser les modalités d’application de l’AI Act, mais les discours géopolitiques contradictoires compliquent la tâche. En tant qu’entreprise opérant à l’échelle mondiale, nous devons composer avec une réglementation locale qui se précise encore dans un contexte de tensions géopolitiques entre les États-Unis, l’Europe, l’Asie, etc.Pour nous, cela se traduit par une certaine incertitude quant à la grille de lecture à adopter et aux mesures concrètes à mettre en œuvre. Les modalités d’application commencent à se préciser, et nous devons nous préparer en conséquence, tout en gardant à l’esprit que ces décisions auront des répercussions importantes sur nos activités opérationnelles.

Adrien Basdevant :

Vous avez raison de souligner que, aujourd’hui, l’implémentation n’est pas claire. Je suis entièrement d’accord : ce n’est pas clair. Il faut rappeler que cela relève d’une spécificité de la réglementation européenne. On peut distinguer deux approches : la gouvernance et la régulation. La gouvernance repose sur des mécanismes de coopération volontaires (à l’instar de l’OCDE), sans sanctions en cas de manquement, tandis que la règle de droit est contraignante et s’applique principalement au niveau régional. Il est difficile d’obtenir un texte harmonisé internationalement. En conséquence, nous voyons une déclinaison de ces règles au niveau européen et au-delà, en fonction du marché visé. Que vos systèmes produisent un effet au sein de l’Union européenne ou ciblent des personnes situées en son sein, la réglementation s’appliquera, indépendamment de l’endroit où vos modèles ont été entraînés.Ce qui est important, c’est de suivre l’évolution des réglementations de manière régulière – mensuellement voire hebdomadairement selon votre secteur. Pour donner un exemple concret, le code de pratique sur les modèles de fondation, qui est la brique de base de ce que l’on appelle, dans le domaine marketing, l’IA générative, est en cours d’élaboration. Quatre drafts sont prévus : le troisième sera publié la semaine prochaine et le quatrième avant mai, afin d’être en place en août. Pour ceux qui travaillent avec des LLM, des LVM ou d’autres modèles, il est crucial de suivre ces évolutions. Nous ne pouvons pas dire que tout sera totalement clarifié, tout comme le RGPD l’a été pour les données personnelles après de nombreuses années.

L’Europe ajoute ainsi une couche de complexité pour aider les acteurs à naviguer dans le monde de l’innovation. Ce processus de simplification, impulsé notamment par le président de la République française et par Van der Leyen lors du dernier sommet, vise à éviter la dérégulation prônée par les Américains, en déclinant le cadre existant à travers des codes de pratique.

Jean Remon :

Merci beaucoup Adrien. Pour être très clair, quand je parle d’incertitude, il s’agit de celle qui entoure l’application de ces règles pour nous, et des défis opérationnels que cela représente. Mon impression, en sortant du sommet, est qu’en fonction des affrontements géopolitiques, nous pourrions nous retrouver avec un cadre régulatoire dont l’application serait plus ou moins contraignante. Cela pourrait avoir des répercussions importantes en termes de charge de travail et de capacité à mettre en œuvre des solutions innovantes.Ce qui est particulièrement intéressant, c’est que désormais, l’IA fait partie intégrante de l’économie réelle. Nous pourrions avoir, par exemple, les mêmes discussions si nous étions fabricants de voitures confrontés aux problématiques de gestion de l’acier. L’IA a ainsi franchi un cap : nous ne rêvons plus, nous intégrons simplement cette technologie dans la complexité du monde économique.

Nicolas Le Menn :

Avant de passer à un autre sujet, j’aimerais évoquer un point intéressant abordé lors du sommet : le retour en force de l’open source.Hugo Abraham :

Aujourd’hui, l’open source revient en force. On a pu observer plusieurs phases autour de l’IA. D’abord, il y a eu cette crainte – voire l’interdiction tacite – de donner accès à trop de puissance. Puis, l’open source a été valorisé pour sa transparence. Aujourd’hui, on le conçoit plutôt comme un moteur d’innovation, un levier de déplacement dans la chaîne de valeur économique. Par exemple, l’arrivée de modèles comme DeepSeek R1 remet en question les anciennes logiques économiques : des LLM providers comme anthropique, comme Mistral, semblent désormais se déployer dans un contexte où leur « moat » parait moins impressionnant.Pour clarifier, il est complexe de définir précisément ce qui est “open” dans l’open source appliqué à l’IA, tant il existe de couches – données, algorithmes d’entraînement, architecture des modèles et poids entraînés. Prenez par exemple Deepseek R1 : il s’agit d’un modèle exécutable sans problème, mais dont la provenance des données et les détails de la boucle d’entraînement restent flous. Toutefois, le fait d’avoir publié les poids en open source permet à de nombreuses projet, comme Open Deepseek R1 de Huggingface, de reproduire intégralement ce modèle.

Il y a quelques années, Huggingface avait lancé Bloom – un LLM open source réalisé en collaboration avec le CNRS – qui, malgré des résultats encourageants, n’a pas véritablement pris son essor. Aujourd’hui, une nouvelle initiative semble se dessiner, notamment en Europe, avec des acteurs comme l’Inria et d’autres centres de recherche. La question est de savoir comment construire un écosystème open source favorisant la coopération, surtout dans le cadre des nouveaux plans de données annoncés par la Commission et le président français. Cela permettrait de repositionner la chaîne de valeur, en particulier dans la mise en action de l’intelligence artificielle.

Nicolas Le Menn :

Il y a effectivement un changement de paradigme. Il y a six mois encore, nous avions une vision différente des enjeux. Aujourd’hui, il apparaît clairement que la stratégie autour des LLM n’est plus uniquement une question de déploiement mais aussi de modèle économique et de gouvernance.Adrien Basdevant :

Ce qui m’intéresse avant tout, c’est l’intégration des LLM au sein de l’architecture d’entreprise. Il ne s’agit plus seulement de développer la technologie, mais de l’industrialiser et de la rendre opérationnelle pour les collaborateurs. On doit penser à la sécurité, à l’architecture complexe des systèmes et surtout à la formation.Les LLM, souvent présentés sous forme de chat ou d’interface en langage naturel, paraissent simples à utiliser. Pourtant, ils nécessitent une compréhension technique minimale pour être exploités correctement. La véritable difficulté réside dans leur intégration dans l’écosystème de l’entreprise et dans l’industrialisation des processus, notamment pour garantir la constance et la fiabilité des résultats, qui reposent toujours sur une inférence statistique.

Hugo Abraham (suite) :

Chez WedR, nous faisons face à ce défi en structurant l’architecture autour d’agents spécialisés. L’idée est de découper les tâches pour ne pas surcharger le LLM et pour permettre des tests et validations à chaque étape. Ce travail d’architecture – ou d’industrialisation, comme j’aime parfois le qualifier – s’inscrit dans une dynamique où des acteurs comme Huggingface trouvent de nouveaux modèles pour faire vivre l’open source. Il s’agit véritablement d’une transition vers le concret dans l’IA.Adrien Basdevant (complément) :

Il est clair que nous avons trop souvent été focalisés sur le LLM en lui-même, alors qu’en réalité, la couche applicative par-dessus, celle qui permet aux agents d’interagir, est ce qui importe réellement. Nous assistons à l’émergence d’agents capables de raisonner et d’interagir en langage naturel, un concept qui, certes, existe depuis les années 1990, mais qui aujourd’hui soulève de nouvelles questions de sécurité et de gouvernance.Par ailleurs, la manière dont l’open source est envisagé dans l’IA diffère fondamentalement du code traditionnel. Les enjeux liés aux données et à leur exploitation représentent un nouveau défi. Dans un papier rédigé il y a huit mois avec des chercheurs de Stanford et Columbia, nous avons décrit en détail ces différents ensembles, démontrant que si les modèles open source peuvent rivaliser en précision avec les modèles propriétaires, c’est surtout au niveau de leur application concrète que se joue la donne.

Hugo Abraham :

La question demeure : jusqu’où peut-on compter sur l’open source quand il s’agit d’instancier et de déployer ces modèles ? Il faudra toujours des infrastructures lourdes pour les rendre accessibles au public, ce qui soulève des enjeux en termes de souveraineté économique.Jean Remon :

Je pense qu’il y a une prise de conscience progressive. Notre besoin n’est pas uniquement de disposer d’experts en algorithmie, mais aussi de personnes capables de concevoir des modèles pour comprendre et traduire des phénomènes en code ou en équations. Les organisations doivent monter en compétences sur ces sujets, tant du point de vue technique que scientifique. C’est cette compréhension qui permettra de recruter les profils adéquats pour gérer les enjeux complexes de l’IA.Hugo Abraham :

Mon avis, c’est une question de prise de conscience. Ce que tu viens de citer correspond typiquement à la formation d’une personne issue de mathématiques, d’ingénierie ou de physique — disciplines dans lesquelles j’ai moi-même été formé. Il s’agit de problématisation, c’est-à-dire de rendre un problème abstrait afin de pouvoir le résoudre. Aujourd’hui, nous rencontrons de nombreuses personnes formées de cette manière, à divers niveaux. Même en tant que généraliste, je constate qu’il est crucial de prendre conscience du champ de bataille sur lequel nous évoluons et d’organiser notre action.Jean Remon :

Absolument. Cela me tient particulièrement à cœur, car on parle souvent d’un manque de ressources dans le domaine de l’intelligence artificielle — un terme vaste et parfois flou. Pourtant, quand on regarde le nombre de doctorants qui sortent des laboratoires et peinent à trouver un emploi, on réalise qu’ils sont parfaitement capables de modéliser un problème, de le mettre en équation, de coder et d’optimiser des paramètres. En réalité, il faut simplement savoir exploiter les ressources qui existent.

J’ai remarqué que cette richesse en savoir-faire a été mise en avant lors du dernier sommet, où Adrien soulignait l’importance de l’écosystème français. Il est essentiel de rappeler que nous disposons d’une double compétence : d’un côté, des experts capables de mener des recherches pointues sur les algorithmes et, de l’autre, une grande richesse de professionnels aptes à construire des modèles et à ajuster des paramètres. Il faut insister sur ce point.

Par ailleurs, concernant l’incertitude, il faut aussi noter que, malgré la richesse de l’écosystème, des annonces récentes — comme le frein envisagé sur le dispositif jeune docteur dans le cadre du crédit impôt recherche — visent à faciliter l’accès des jeunes docteurs aux entreprises.Nicolas Le Menn :

On avait dit ambivalence…

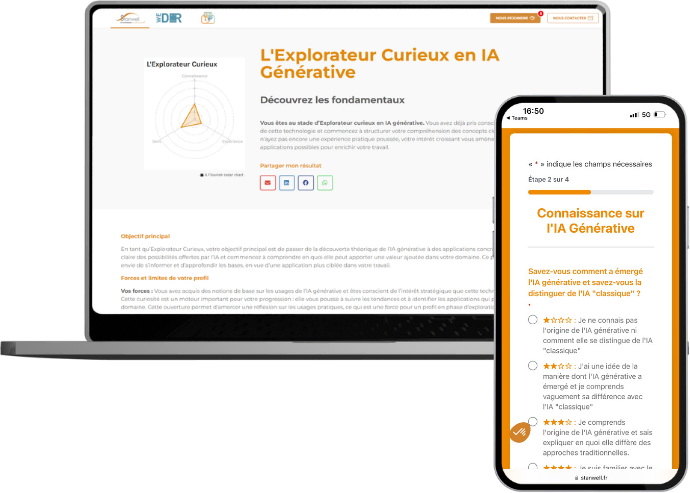

Évaluez votre maturité IA GEN en moins de 10 minutes avec notre Diagnostic gratuit

Recevez une analyse personnalisée, des contenus en ligne adaptés et échangez avec nos experts pour vous aider à progresser.

📌 Pour aller plus loin sur l’intelligence artificielle, la régulation et l’industrialisation des modèles :

👉 L’IA générative : une transformation pour les ressources humaines et l’expérience collaborateur

👉 Interactions clients augmentées : le pouvoir transformateur de l’IA

👉 La montée en puissance de l’éthique dans les entreprises face à l’intelligence artificielle

👉 Développer les compétences en IA générative : profils de maturité et recommandations

👉 La révolution de la compétence bancaire : l’IA générative comme catalyseur